Swama を使えば、たった数行のコマンドで、Macに最高のローカルAI環境を構築。

トランスエヌ株式会社(本社:東京都、代表取締役:那小川、以下 Trans‑N)は、MacOS上で大規模言語モデル(LLM)を軽量・高速にローカル実行できるオープンソース基盤 「Swama(スワマ)」 を公開しました。

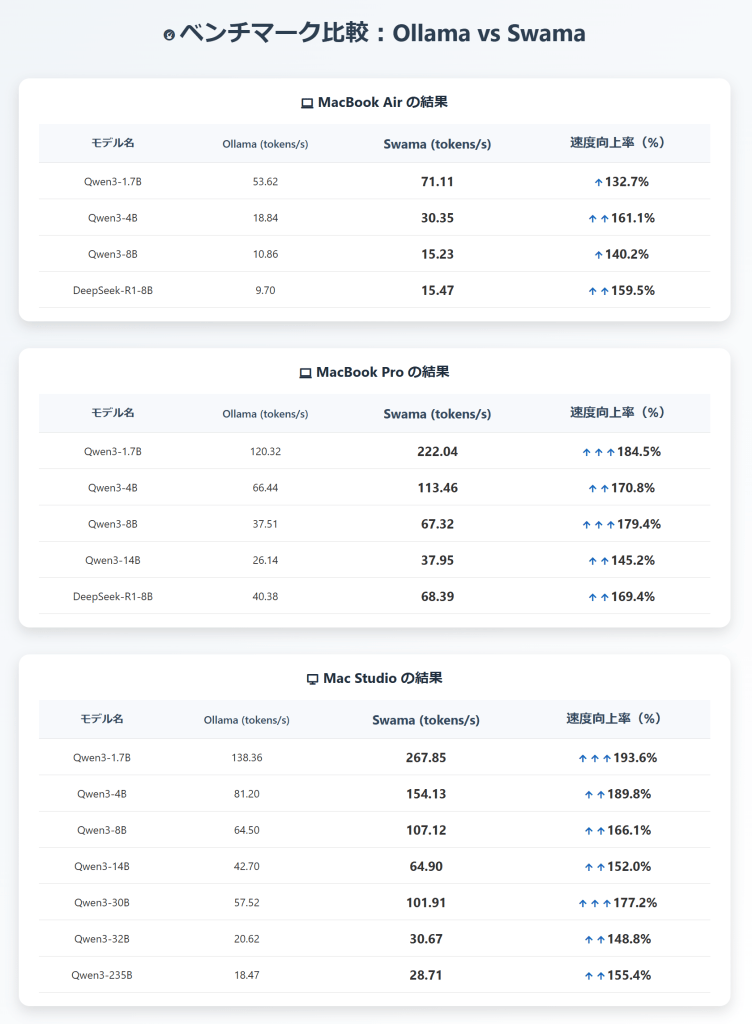

ローカルLLM実行基盤で最も広く利用されているOllamaをMacOS向けに最適化するため、Apple純正プログラミング言語「Swift」と、Apple開発の機械学習フレームワーク「MLX」を採用し、Apple 純正スタックでゼロから開発しました。その結果、Macの各機種・モデルでの検証において、基準のOllamaより処理速度を約1.5~2.0倍に向上させることに成功しました。※

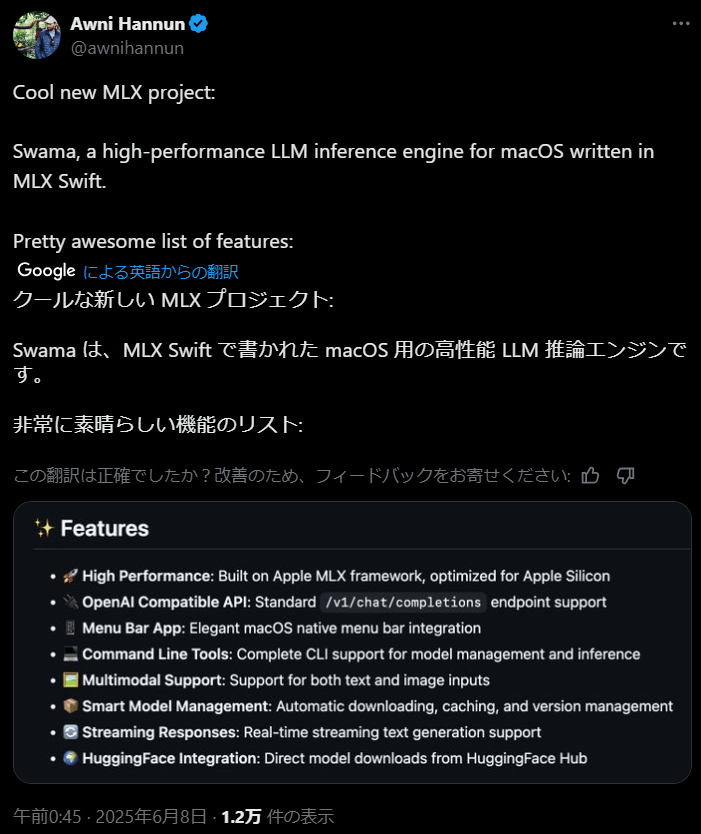

Swamaはリリース後Appleの機械学習リサーチサイエンティストのAwni Hannun氏(論文引用数26,000回以上)により高く評価されています。

※評価指標のtokens/s: 「トークン」はモデルが文章を理解・生成する際の基本単位。tokens/sは1秒あたりに処理できるトークン数を表し、大きければ処理能力が高いことを示します。

Swama の主な特長 ── Macで最高のローカルAI体験を提供できる理由

- Macの言語でまるごと開発

Apple純粋プログラミング言語 「Swift」のみで作られているため、Mac 専用にチューニングされた “素の速さ” をそのまま発揮します。 - Apple の AI エンジンをフル使用

Apple 製の機械学習エンジン「MLX」を採用。Mac の CPU・GPU・Neural Engine を同時に動かし、AI 計算を一気に加速します。 - OpenAI APIと互換性

/v1/chat/completionsなど OpenAI と同じ API で呼び出せるので、RAG やチャットアプリなど既存のツールチェーンに “設定を変えるだけ” でつながります。 - テキストも画像もOK

文章生成だけでなく、画像を読み取って答えることも可能。Mac 1 台でリッチな生成 AI 体験が完結します。

開発責任者コメント

GPU依存の旧プロダクトでは Mac 上での LLM 推論が遅く、求める機能も満たせませんでした。そこで、Mac Studio ベースの自社一体機「N-Cube」で培った知見を活かし、Swift × MLX でゼロから再構築したのが Swama です。

CLI/API 形態は既存ワークフローにシームレスに統合でき、しかも Ollama 単体比で 1.5〜2 倍の速度を達成。オープンソースとして公開することで、Apple エコシステムにおける生成 AI 開発をさらに活性化し、より多くのユーザーへ高性能なローカル AI 体験を届けたいと考えています。

— Trans-N Head of Engineering 孫星越